Azure – die Cloud Wundertüte von Microsoft – 1433

Lesezeit: vergnügliche 6 Minuten

1. Content

Tja, wo soll ich hier bloß anfangen? Festzuhalten ist erst einmal die allgemeine Aussage:

“Wir brauchen mehr Digitalisierung und KI, wir müssen in die Cloud und die Welt wird gut!” – in früheren Zeiten sagte man übrigens: “Oh Herr, wir brauchen ein Wunder!”.

Es ist wohl langsam an der Zeit, diesen Hype mal aufzurollen – und um dann in dem konkreten Beispiel MS Azure und Virtual Desktop zu münden.

Zum Thema KI mit Terminator und dem Aufstand der Maschinen oder mit Vollendung Beethovens 10. unvollendeter Sinfonie – weil vorher gestorben – durch KI folgt dann noch ein extra Beitrag, versprochen!

Werbung

2.Historisches

Alles begann eigentlich in der Computersteinzeit 1998 mit VMware und den beiden Informatikern Mendel Rosenblum und Diane Greene. Ziel war es, eine Technik zu entwickeln, um physische Computersysteme mit Hilfe von Software abzubilden und zu abstrahieren – also virtuelle Server oder eben VMs. Wieso? Die Hardware wurde immer leistungsfähiger und so ein richtig dicker physischer Server war mit nur einer einzelnen Datenbank nur noch gelangweilt.

Jetzt einfach alle DBs und Anwendungen eines Unternehmens auf einen einzelnen – oder auch mehrere – dicke Server zu packen, wäre zwar prinzipiell möglich, aber keine so gute Idee. Da beeinflusst sich dann irgendwas untereinander und gegenseitig, die Fehlersuche wird zur reinsten Katastrophe und Alptraum – und muss das dicke Ding mal neu gestartet werden, liegt gleich die ganze Firma lahm, nicht gut.

Also Hyperviser drauf, der dem OS und der DB einen Server vorgaukelt und die dicken Ressourcen an RAM und CPU einfach auf diese virtuellen Server verteilt bzw. zuteilt – so ein virtueller Server lässt sich dann auch prima mal neu starten, ohne gleich den ganzen Rest lahm zulegen.

Übrigens läuft auch eine Linux VM unter Windows problemlos auch auf einem völlig altersschwachen Laptop – naja, mit gewissen Reaktionszeiten und allzu eilig sollte es man auch nicht haben – aber einfach mal so zum ausprobieren.

3. The next Step

Jetzt treffen gleich zwei glorreiche Erkenntnisse aufeinander. Amazon erkannte 2002 das Problem eigener ungenutzter Serverkapazitäten in seinen Rechenzentren – also Leerlauf – und dachte sich: “Wieso diese eigentlich nicht verscherbeln – also verkaufen und zu Kohle machen?”.

Auf Anwender- bzw. Unternehmensseite bestand jetzt einer dieser neuen virtuellen Server nur noch aus einem .vmdk File und die Frage war: “Wieso die eigenen dicken Server im Keller noch selbst weiterbetreiben und nicht einfach zu Amazon schieben?”.

Kohle gespart, Amazon happy, eine Win Win Situation – alles gut!

Hier hat das Cloud Computing also seinen Anfang und nahm schließlich seinen Lauf.

Nach Amazon mit seinem Elastic Cloud Computing EC2 und heute AWS kamen schließlich 2008 die Google Cloud und 2010 Microsoft mit Azure dazu.

Ach so, und es gibt noch die interessanterweise sehr erfolgreiche Alibaba Cloud oder auch bekannt unter Aliyun – zwar in Singapur registriert – aber trotzdem möchte ich da nicht meine Daten oder Website ablegen, sonst stehen auf einmal noch komische Typen bei mir vor der Tür.

Oder meine F&E Ergebnisse werden zur Beute des roten Drachen und irgendein dubioses Start-up bringt auf einmal ein Produkt auf den Markt, was technologisch genau auf meiner Entwicklung aufbaut – seltsam.

4. Heute

Diese genannten Cloud Services haben sich bis heute zu waren Ökosystemen im Computing weiterentwickelt und bieten – neben klassischen Storage und VMs – Services, Dienstleistungen, Apps und noch mehr an, die alles Bisherige umkrempeln und in Frage stellen. Alleine die MS Azure Cloud besteht aus mittlerweile 17000! zertifizierten Apps und Diensten und es gibt nichts, was man da bei MS nicht buchen könnte!

Einen kurzen und unterhaltsamen Überblick liefert die Azure Startseite:

Beispiel gefällig? Programming! Herkömmliche Anwendungen wurden einmal programmiert, sind monolithisch, in Stein gemeiselt und lassen sich nur schwer ändern. Heutige Anwendungen dagegen bestehen aus zugebuchten Services – Stichwort Cloud native Programming und MicroServices – und bieten neue Möglichkeiten hinsichtlich Sicherheit und Skalierbarkeit.

Evtl. erscheint es sinnvoll, eine Ein- und Ausgabe Warteschlange – eine Queue – vom Rest der Applikation zu trennen. Läuft diese Warteschlange jetzt über – Stichwort DDoS Attacke oder verteilter Dienstverweigerungsangriff, so reißt das nicht gleich die gesamte Applikation mit in den Abgrund. Dazu bietet alleine Azure eine Reihe von fünf Services zur Queue Verwaltung mit unterschiedlichen Schwerpunkten und zur Entkoppelung bzw. Elastizität einer Anwendung:

Azure Event Grid, Azure Event Hubs, Azure Service Bus, Azure Notification Hubs und Azure Queue Store … hier steige ich jetzt aber aus, wer sich mehr davon geben möchte gerne unter:

Noch mehr? Gerne – Datenbanken!

“Wählen Sie zwischen vollständig verwalteten relationalen, NoSQL- und In-Memory-Datenbanken, für die proprietäre sowie Open-Source-Engines zur Verfügung stehen. Fokussieren Sie sich auf die Erstellung innovativer Anwendungen, und profitieren Sie von den Vereinfachungen, die Ihnen Azure dabei bietet. Vollständig verwaltete Datenbanken automatisieren Aufgaben wie das Konfigurieren und Verwalten der Hochverfügbarkeit, der Notfallwiederherstellung sowie von Sicherungen und der regionsübergreifenden Datenreplikation, wodurch Sie Zeit und Geld sparen können. “

Und weiter im bunten Galopp:

“Profitieren Sie von fortschrittlichen Sicherheitsfunktionen, der Auswahlmöglichkeit zwischen Hochverfügbarkeit in derselben Zone oder mit Zonenredundanz und einer SLA (Vereinbarung zum Servicelevel) von bis zu 99,99 Prozent. In diesem Migrationsleitfaden erfahren Sie, wie Sie Ihre lokale MySQL-Datenbank zu Azure migrieren.“

Yo Bro and Sis … yes, was rauchen die da eigentlich bei MS? Das Zeugs hätte ich auch gerne … take this:

So geht es weiter z.B. mit Services zu Sicherheit und Zugriffskontrolle – dem Azure Active Directory, zu Migration von on premise in die Cloud, zu Verwaltung und Governance bis hin zu KI und Machine Learning – Azure Bot Service für die Kundenkommunikation. Und schon sind wir wieder bei Terminator und dem Aufstand der Maschinen.

Werbung

5. Azure Virtual Desktop

Doch jetzt zum eigentlichen Thema: Azure oder Windows Virtual Desktop WVM und Cloud basiertes Deployment von Arbeitsplätzen, die eigentlich logische Weiterentwicklung von virtuellen Servern!

Wow, aber eigentlich ein schon sehr alter Hut, sorry. An die etwas Älteren unter uns: wir erinnern uns noch an Citrix und Thin Clients? – und an die Jüngeren unter uns: schon mal gehört? Genau! Damals kostete Hardware noch richtig Kohle und man setzte eben nur einfache Geräte zur Ein- und Ausgabe ein – quasi nur Bildschirm und Tastatur, während der eigentliche Desktop auf dem Server im Keller lief. Oder es bestanden Zutrittsbeschränkungen wie z.B. Reinraum in Pharmaunternehmen und der Admin konnte da nicht einfach so mal reinhuschen und nachschauen oder was richten.

Und überhaupt wiederholt sich die IT immer wieder mit eigentlich uralten Konzepten nur unter neuen hypen Namen – nur so mal am Rande.

Egal, das Konzept bietet schon neben den ganzen Cloud Vorteilen wie Kostenreduzierung und Sicherheit durch einen großen Anbieter weitere Vorteile – auch wenn facebook da gerade failed.

-

im Büro: Laptop einfach zuklappen und dann Zuhause im HomeOffice eigenen Laptop wieder an – und genau an der Excel Tapete oder Powerpoint weitermachen, an der man vorher gearbeitet hat … schon cool

-

leistungsstarke CPU, Graphikkarte, Arbeitsspeicher? Egal – brauchen nur noch Gamer, der Desktop läuft auf jedem Ausgabegerät, egal ob Laptop, Tablet oder Smartphone

-

Sicherheit: der Anbieter – also hier MS – kümmert sich um die Sicherheit seiner Rechenzentren, z.B. DDoS Abwehr und damit um die Sicherheit der Nutzerdaten. MS betreibt deshalb sogar ein Rechenzentrum für DE genau in Frankfurt – wobei es dem Hacker von Büro 121 ziemlich egal sein wird, wo der Server denn jetzt im Netz hängt

-

Kosten: na klar – alles genau kalkulierbar und bitte an MS zahlen. Keine dubiosen und unfähigen Dienstleister mit völlig überhöhten Forderungen mehr

-

Skalierbarkeit: Das eigene Forschungs- oder Entwicklungsprojekt braucht auf einmal mehr Rechenleistung, es besteht höherer Workload wegen neuen notwendigen Simulationen? Dazu buchen – no problem!

Werbung:

Zum Schluss und Ausblick

Puh, erst mal wieder runterkommen! Klar, jeder neue Weg zeigt erstmal tausend neue Fragen auf.

Vor allem drängt sich hier die Frage zu Hyprid Cloud Lösungen auf: wie z.B. geht das Ganze mit on premise und Cloud zusammen? Lokales AD mit Azure Directory Services spiegeln? DBs von der Public in die Private Cloud spiegeln?

Nicht zu vergessen: es braucht immer eine richtig fette Mbit Internetverbindung – hat der Bagger auf der Nachbarbaustelle mal das Kabel gekappt, ist es aus und vorbei!

Das neue Stichwort heißt deshalb Hybrid Cloud, von beiderlei Wesen, also eine Mischung zwischen on- und offline, damit in einem solchen Ernstfall wenigstens das Wichtigste noch läuft.

Und weiter geht es mit Security, Datenschutz und DSGVO, ISO 27001, Tracking oder Sicherheit vor Manipulation durch den Big Player, whatever … wir erinnern uns an Alibaba Cloud … und das sind nur einige der vielen weiteren Fragen, die in einer konkreten Strategie dediziert aufgearbeitet und immer wieder hinterfragt und angepasst werden müssen … sonst wird das nix!

Und ganz zum Schluss nochmal kurz zurück zum Machine Learning, IoT und Predictive Maintenance Lösungen mit Azure … Windräder! Ja wirklich Windräder! Die haben doch tatsächlich mechanische Getriebe und die gehen schon mal kaputt … schwer zu erreichen und zu reparieren, da in zig hundert Metern Höhe eingebaut. Jetzt versieht man ein solches Getriebe einfach mit Sensoren, die den Lauf und die Vibrationen eines solchen Getriebes messen und kann dann vorhersagen – also predictive – ob, wann und welches Bauteil dieses Getriebes als nächstes denn Geist aufgibt. Und eben schon mal Ersatzteile, Kran oder gleich Helikopter vorbestellen und alles vorbereiten … prima, läuft!

Egal, wir Tekkies zusammen rocken das Ding und werden unseren heutigen Planeten zu einem besseren Ort machen, ganz sicher!

Werbung:

4×3=34?

KPIs und SLAs in der IT auf den Punkt! – 529

Lesezeit 3 Minuten

„Do you see difficulties in every new opportunity or opportunities in every new difficulty?“

Content:

Besonders hohe Bedeutung für ein effizientes IT-Controlling spielen Key Performance Indicators und Service Level Agreements – die eben – wie der Name schon sagt – Leistungen und Services sichtbar, quantitativ fassbar und dadurch letztendlich bewertbar machen sollen.

Kurz zum Unterschied: KPIs kommen mehr intern zum Einsatz und bewerten z.B die Leistung des Service Desk oder die Performance eines Projekts, SLAs finden dagegen zumeist in der Bewertung der Leistung eines externen Dienstleisters ihren Einsatz und regeln darüber hinaus auch noch weitere Aspekte wie Definition von Art und Umfang der Serviceerbringung oder auch strategische Aspekte wie z.B. langfristig geplanter Ausbau der IT Infrastruktur.

So weit, so gut – doch jetzt zum eigentlichen Problem:

KPIs und SLAs sind zunächst einmal Indikatoren, die die Realität in Zahlen fassen – statistische Kenngrößen wie z.B. eben der Mittelwert, Prozentangaben oder absolute Zahlen.

Zahlen sind immer gut, gerade in der IT – Zahlen sind objektiv und unbestechlich – wir lieben Zahlen und wir glauben an Zahlen!

Aber stimmt das wirklich???

Werbung

Tasten wir uns an das Problem heran mit dem klassischen Beispiel über die Aussagekraft eines Mittelwertes:

Mit meiner linken Hand fasse ich in das Gefrierfach meines Kühlschranks mit -30 Grad, die Rechte lege ich auf eine Herdplatte mit 100 Grad – ergibt einen Mittelwert von 35 Grad [(100-30)/2], also alles in bester Ordnung!

Und so geht es in der Welt der IT mit diesen bunten KPIs und SLAs munter weiter.

Mittelwert:

Ein beliebtes Beispiel: ein externer Dienstleister garantiert eine mittlere Reaktionszeit von 1,5 Stunden und die monatliche Auswertung ergibt auch exakt diesen Wert – alles prima! Bei genauerer Betrachtung hat dieser Dienstleister aber in einigen Fällen schon nach 10 Minuten zurückgerufen, manchmal aber auch erst am nächsten Tag – Gefrierfach und Herdplatte eben.

Was ist hier passiert? Der absolute Mittelwert hat ohne ergänzende Angaben zur Range keinerlei Aussagekraft – oder man nimmt gleich den Median – alle Werte werden ihrer Ausprägung nach sortiert und der Median gibt dann den 50 Prozent Schnitt an.

Prozentangaben:

Ein weiteres beliebtes Beispiel: da garantiert z.B. ein externer Dienstleister eine Serververfügbarkeit von 99 Prozent – wow, das sieht klasse aus!

Kurz den Taschenrechner bemüht ergibt das aber einen Ausfall von 87.6 Stunden über das ganze Jahr gerechnet [(365×24)x0,01] und sieht – so betrachtet – nun nicht mehr wirklich toll aus – für einen Webshopbetreiber völlig inakzeptabel.

Was ist hier passiert? Nun, der Indikator und die Messgröße wurden falsch gewählt! Nicht die garantierte Laufzeit, sondern die maximale Ausfallzeit ist entscheidend – und dann bitte in Stunden oder Tagen und nicht in Prozent – glatter Fall von Augenwischerei.

Absolute Anzahl:

Alarm im Service Desk! Die Anzahl ungelöster Tickets im System ist in der letzten Woche rasant angestiegen! Doch bei genauerer Betrachtung ergibt sich: alles nur völlig unwichtige Prio 4 Tickets – also Incidents, die niemanden wirklich stören oder von der Arbeit abhalten – halt nur etwas nervig.

Was ist hier passiert? Selbst absolute – scheinbar objektive – Zahlenwerte müssen stets hinterfragt und mit zusätzlichen qualitativen Informationen hinterlegt und untermauert werden, bevor es zu einer Bewertung der Situation kommen kann.

Fazit:

Ganz einfach: genau hinsehen, hinterfragen, nochmals hinterfragen:

“Was sagt mir diese Kennzahl jetzt genau?”

Und vor allem einen anderen Blickwinkel einnehmen – und schon gar nicht an Zahlen glauben!

Werbung

the nextGen IT – 522

„Do you see difficulties in every new opportunity or opportunities in every new difficulty?“

Lesezeit 4 Minuten

um es gleich auf den Punkt zu bringen:

der Informations- und Kommunikationstechnologie kommt in heutigen Unternehmen ohne Zweifel eine überragende Rolle hinsichtlich Innovation und Wettbewerbsfähigkeit zu und diese Bedeutung wächst stetig.

Doch wie muss eine typische IT-Abteilung im Unternehmen heute aufgestellt sein, um dieser Rolle voll und ganz gerecht zu werden?

Hier gibt es neue Ansätze!

1. Daily Business

Zunächst einmal sollte die IT im Unternehmen im Tagesgeschäft völlig geräuschlos und im Hintergrund laufen. Die originäre Aufgabe hier besteht darin, alle Systeme optimal am Laufen zu halten und den Anwender mit seinen Fragen zusätzlich perfekt zu unterstützen und mit einem Lächeln im Gesicht zu hinterlassen.

Zentraler Bestandteil ist natürlich ein schlagkräftiger Service Desk, der am besten eine über 100 Prozent Erstlösungsquote aufweisen kann.

Mit Auswertung von Zahlen aus der Vergangenheit, mit Definition von prädiktiven Kennzahlen und Einsatz von KI [python] sowie mit ständigem Testen von typischen Anwendungsszenarien können hier mögliche Software- oder Userfehler schon im Vorfeld ermittelt werden – also noch bevor sie auftreten – und entsprechend proaktiv darauf reagiert werden.

Weiter muss der Service Desk entsprechend qualitativ und quantitativ aufgestellt sein, sollte trotz allem dennoch mal ein Fehler durchdringen.

Als simples Beispiel lässt sich etwa das zu erwartende Anrufaufkommen an einem bestimmten Wochentag – vormittags oder nachmittags – durch Auswertung von Vergangenheitsdaten ermitteln und die Hotline entsprechend besetzen – kein Anwender hängt gerne stundenlang in der Warteschleife.

Generelle Zielsetzung im daily Business muss eine positive und durch Kommunikation und Kooperation geprägte UX sein.

Werbung

2. Wertschöpfungsbeitrag

Generell läuft es heute immer noch so: die Fachabteilung kommt mit einer bestimmten Anforderung auf die IT zu, die IT ermittelt und sagt geht nicht oder geht doch und setzt dann diese konkrete Anforderung der Fachabteilung um.

Die Stoßrichtung hier muss jedoch eine Andere sein, da die Fachabteilung sowieso oftmals keine Ahnung hat. Vielmehr ist es Aufgabe der IT, neue technische Möglichkeiten und Trends hinsichtlich Mehrwert für das Unternehmen unter Beachtung von Compliance, Budget und Risikoabschätzung zu bewerten und für einen möglichen Einsatz im Unternehmen zu evaluieren.

In diesem strategischen Ansatz nimmt die IT nicht mehr die typische reaktive Position ein, sondern geht proaktiv und mit konkreten Vorschlägen auf die Fachabteilung zu. Die IT selbst wird zur aktiven und treibenden Kraft in der Weiterentwicklung der Infrastruktur, der Prozesse und Services und trägt so – im Rahmen der Unternehmensstrategie – proaktiv zur Steigerung der Wertschöpfung und Wettbewerbsfähigkeit des Unternehmens bei.

Werbung

3. Perspektive

Um der oben beschriebenen Aufgabe gerecht zu werden, muss die IT-Abteilung natürlich ihren heilen rosaroten Technikplaneten verlassen und auch andere Perspektiven einnehmen – so gibt es vielleicht neue technische Lösungen, allerdings recht teuer und der Verantwortliche im Controlling bekommt gleich einen Herzkasper. Oder es gibt faszinierende neue technische Lösungen, die in der Praxis jedoch nur wenig verändern und nur echte ITler begeistern können.

Ohne Zweifel, die Sachlage verkompliziert sich erheblich, sobald man seinen heilen rosaroten Technikplaneten verlässt. Bevor man sich jetzt in dem Dickicht und Details aus Strategie, Budget, Risiko und sonstigem völlig verirrt, gibt es eine einfache Lösung und Orientierung – die simple Frage: „was hat der Anwender bzw. Kunde oder das Unternehmen letztendlich davon?“

Eine solche komplexitätsreduzierende und einfache Metaperspektive hilft hier ohne Zweifel weiter!

Werbung

Das Rosettenrätsel – 27

Digital 2020? – 837

Werbung

Lesezeit 4 Minuten

Digital 2020? Kurze Einordnung und eine Studie der Unternehmensberatung Kearney – 837

Schöne neue Welt! Da reibt man sich doch nur noch völlig verwundert die Augen und wähnt sich gleich im Jahr 2035:

Die Chinesen sind auf dem Mond gelandet, sammeln dort Steine ein und bringen diese auch noch auf die Erde zurück [vorerst noch unbemannt] – und sind auch schon auf dem Mars gelandet [vorerst ohne Steine zurück zu bringen und nur mit Raumsonde]!

Und die EU will den Hyperscalern wie AWS [schon seit 2006], Azure oder Google Cloud [beide 2010] mit GAIA-X Konkurrenz machen und damit zu einem besonders sicheren und vertrauenswürdigen, vor bösen Mächten geschützten, Technologie- und Datenknoten weltweit aufsteigen.

Weiter ist 5G und IoT in aller Munde – vollständig autonomes Fahren sowieso – und – etwas weniger dramatisch – endlich hat sich Home Office durchgesetzt, wir skypen und zoomen nur noch mit unseren Colegas.

Sogar an Schulen gibt es endlich Tablets und digitale Lernplattformen.

Und sogar meine Steuererklärung kann ich mittlerweile digital über das Netz einreichen und von Dokumenten auf Papier wird explizit abgeraten. Hui!

Aber stimmt das alles wirklich? Wie sieht die digitale Realität 2020 wirklich aus?

Nun, EU GAIA-X scheitert wohl an nationalen Interessen und Datenschutzbestimmungen – schöne Grüße von der DSGVO – und zusätzlich befremdlich erscheint, dass auch Alibaba und Huawei – sicher auf völlig korrekten Ausschreibungswegen – zu den Gründungsunternehmen dieser besonders vertrauenswürdigen und sicheren EU Datenwolke gehören.

5G wird wohl nur in einzelnen Campus Hotspots als Ergänzung zum WLAN umgesetzt und es gibt immer noch Funklöcher [!], also nix Empfang, gar Nichts – und damit hat sich wohl auch IoT erledigt, wobei auch hier niemand genau weiß, was das denn sein soll – typisches Buzzword.

Mein Fitnessarmband und TV mit Netflix im WLAN reichen mir völlig und mein Kühlschrank soll bitte auch nichts völlig von alleine nachbestellen, das bekomme ich gerade so noch selbst hin – auch wenn ich mich dafür von meinem Laptop verabschieden und vor die Tür muss – grrrr.

Vom vollständig autonomen Fahren haben sich mittlerweile auch alle Automobilhersteller wieder verabschiedet – selbst Tesla – man freut sich ja schon, wenn das eigene Kfz im Stau selbständig bremst und wieder anfährt und halbwegs die Spur hält, nur in Baustellen bei gelben Fahrbahnmarkierungen halt nicht.

Naja, wenigstens Videochat funktioniert, wenn auch ohne die sonst so wichtigen sozialen und informellen Informationskanäle in der Kaffeeküche – und Schulen bekommen gleich 100 Eus pro Tablet, aber wie soll damit bitteschön die minderbemittelte Familie ihrem Knirps oder gleich mehreren ein Tablet damit bezahlen? Aldi?

Und meine voll digitale Steuererklärung ist auch raus – aber auch hier musste ich zuerst einen supergeheimen PIN Code beantragen, der mir dann per Post und berittenem Boten auf Papier zugestellt wurde. Prima!

Werbung

So, jetzt zur eigentlich wichtigen Betrachtung der deutschen Unternehmenslandschaft, hierzu gibt es eine interessante Studie der Unternehmensberatung Kearney mit dem Ergebnis:

Den deutschen Unternehmen fehlt der Mut bei der Digitalisierung und Transformation!

Kearney unterscheidet die befragten Unternehmen dabei in:

“digitale Verweigerer”:

Ja klar, ein Bekleidungshaus mit 175 Jahren Familientradition wird ihrer im Durchschnitt 85 Jahre alten Stammkundschaft keine neuen digital Paymentfunktionen via Smartphone anbieten. Hier liegen die Probleme tiefer.

“digital Klagende”:

Auch klar, habe ich ein Unternehmen irgendwo am Ende eines Industriegebiets und irgendwo im Osten, dann freue ich mich überhaupt über eine Internetverbindung – an Cloud mit großen Datenmengen ist hier gar nicht zu denken, lieber den eigenen Server im Keller weiter laufen lassen.

Zudem gibt es Fragen zum Datenschutz, personenbezogene Daten sollten doch besser auf Servern mit Standort D gespeichert werden – die Telekom Cloud mit eben diesen Standorten ist leider gescheitert und auch dem nordkoreanischen Hacker von Büro 121 ist es sowieso völlig egal, wo denn der Server jetzt im Netz hängt.

“risikoscheue Standard Digitalisierer 40%”:

Man muss eben mitmachen, irgendwie. Immer mehr Lieferanten und Kunden fordern eine digitale und voll integrierte E2E Lieferkette.

Vom eigentlichen Ziel der Digitalisierung – der Weitblick, Zielsetzung und Priorisierung – fehlt jedoch jede Spur.

“nicht disruptive Digitalisierer”:

Die neuen digitalen Potenziale sind wohl erkannt, dennoch möchte man sich vom bisherigen und Umsatz bringenden Geschäftsmodell nicht verabschieden – bitte keine Veränderung!

Auch hier fehlt oft Mut, eine langfristige Zielsetzung und klare Priorisierung – auf Digitalisierung muss aber konsequenterweise auch Transformation folgen.

“ambitionierte digital Getriebene”:

Digitalisierung und Potential sind vollständig erkannt, aber gut gemeint ist nicht immer gut gemacht.

Mut ist vorhanden, aber auch hier fehlt oft langfristige Zielsetzung und klare Priorisierung.

So weit, so gut …

Organisationale Ambidextrie [Beidhändigkeit] heißt jetzt hier das neue Zauberwort und wird zum zeitgemäßen Modell im Rahmen des Digital Leaderships, Exploitation und Exploration!

Bestehendes optimieren und Neues erkunden – Effizienz und Innovation gleichzeitig vorantreiben und zusammenbringen – das wird zur Ausschlag gebenden Bedeutung in diesem Zusammenhang und in der aktuellen Situation.

Werbung

Soweit zum Thema “Digitalisierung und digitale Transformation 2020?” – spannend – und ich möchte mich gerne weiter mit diesem dringenden und wichtigem Thema befassen.

Weiteres auf Anfrage,

Vielen Dank für Deine Zeit / Kind regards – und ich hoffe etwas unterhalten zu haben

die blaue oder die rote Pille?-1014

Lesezeit 5 Minuten

Morpheus zu Neo nach eindrücklicher Warnung und Darstellung zur Matrix: “Wählst Du jetzt die blaue oder die rote Pille?” … nun, eines der wohl berühmtesten Zitate aus der neueren Filmgeschichte und aus dem sicherlich bahnbrechenden Film “Matrix”.

Und weiter: wählt Neo die blaue Pille, so bleibt sein bisheriges und etwas langweiliges Leben als Programmierer in seinen gewohnten Bahnen – nichts wird sich ändern und alles läuft einfach so weiter. Mit der roten Pille jedoch wird er quasi aufgeweckt und landet in der – sicherlich nicht sehr charmanten – Realität!

Allgemein so weit bekannt – nicht das ich hier jetzt irgend jemanden beleidigen möchte – isch schwör yo Bro and Sis!

https://www.youtube.com/watch?v=GL5D7sm9ixo

Aber hier nochmal die Kurzfassung für alle homo neanderthalensis da draußen, die den Film doch tatsächlich nicht kennen sollten.

Was ist passiert? Künstliche Intelligenz oder die Maschinen haben einen Atomkrieg angezettelt – und zwar einen richtig heftigen – Grund oder Motivation dafür erst einmal unbekannt. Die Erde liegt also in Schutt und Asche und die Menschheit ist fast ausgerottet. Die Maschinen stehen jetzt vor dem Problem, woher Energie oder Strom nehmen? Naheliegende Sonnenenergie fällt aus, da sich die Erde durch den Krieg in einem nuklearen Winter befindet und wohl noch für die nächsten zehntausende Jahre von einer kilometerdicken Staubschicht umhüllt ist, durch die kein Sonnenstrahl mehr dringt.

Also versetzen die Maschinen die wenigen noch verbliebenen Menschen in ein künstliches Koma, lagern diese dann in speziellen Tanks und nutzen die Körperwärme zur Stromerzeugung. Damit es diesen menschlichen Batterien nicht allzu langweilig wird, bekommen sie von einem richtig dicken Computer eine halbwegs angenehme Realität direkt in ihr Hirn eingespielt!

Aber es gibt natürlich auch einen Widerstand – Menschen, die noch nicht als künstliche Batterien benutzt werden und die auch nicht in dieser künstlich eingespielten, sondern in der echten Realität leben – Morpheus eben! Und selbstverständlich nimmt Neo die rote Pille und schließt sich diesem Widerstand an, sonst wäre der Film ja schon nach fünf Minuten zu Ende!

Soweit zum Film “The Matrix”. Jetzt noch etwas allgemeines Vorgeplänkel zum Aufwärmen, bevor ich den Hammer der Simulationshypothese von Nick Bostrom auspacke, viel Spaß!

1. Die Realität ist simuliert

Ok, also eine durchaus berechtigte Frage. Wer garantiert mir also, das ich gerade jetzt wirklich vor meinem Laptop sitze und diesen Text tippe? Oder umgekehrt, wer garantiert dir, dass du jetzt gerade vor deinem Laptop sitzt und diesen Text liest? Genau! Es sind eigentlich nur elektrische Impulse, die gerade in erhöhter Anzahl und ziemlich wirr durch mein Hirn flitzen – vielleicht noch etwas abgebremst und modelliert durch den synaptischen Spalt zwischen zwei Nervenzellen.

Aber wirklich ausgelöst durch meine Sinnesorgane? Also Auge, Gehör, Sonstiges? Oder vielleicht doch durch einen dicken Supercomputer eingespielt? Und mein Hirn schwimmt einfach so und heftig verkabelt in einer Nährstofflösung … The Matrix.

Und jetzt? Erst einmal tief Luft holen!

Die Sache mit dieser tatsächlichen Realität und Existenz hat übrigens schon Generationen – vor allem von Philosophen – umgetrieben. Zum Beispiel René Descartes – genialer Denker, Universalgelehrter, Wegbereiter der Aufklärung und der modernen Philosophie – hat dieses Problem ganz pragmatisch mit einem einfachen Satz beantwortet: “cogito ergo sum” – “Ich denke, also bin ich” – und Ende der Durchsage! Ok einverstanden … muss ich aber trotzdem nochmal drüber nachdenken.

Jetzt noch viel weiter zurück in das alte Griechenland. Na klar! Der alte bärtige Plato und sein Höhlengleichnis! Wir sitzen also in einer dunklen Höhle – gefesselt – und sehen nur die rückseitige Wand der Höhle. Alles, was jetzt vor dem Höhleneingang vorbeispaziert – was auch immer – wirft einen Schatten auf diese Wand. Wir können uns ja nicht einfach umdrehen – da gefesselt- und halten die Schatten auf der Wand für die tatsächliche Realität – wow!

2. Die "echte" Realität gibt es nicht

Nur mal so am Rande: “… aber ich sehe doch meine Umgebung und meine Realität, nehme sie war, das muss doch alles echt sein?” … Pustekuchen! Immer noch letzte Zweifel?

Gar nicht mal so weit entfernt vom alten Plato ist die aktuelle Wahrnehmungspsychologie: Diese sagt: “Wahrnehmung ist subjektiv, selektiv und aktiv!”. Es gibt keine “echte” Realität!

Subjektiv? Klar! Und zwar vom Individuum abhängig … fahre ich jetzt mit einem Beifahrer/in durch eine beliebige Stadt, so nimmt mein Beifahrer/in natürlich ganz andere Dinge am Wegesrand war als ich selbst, da ich ja auf Straße und Verkehrsgeschehen fokussiert bin – ich lebe in einer anderen Realität.

Selektiv? Auch klar! Und zwar von der Situation abhängig … habe ich jetzt zum Beispiel richtig Hunger, so fällt mir auf einmal ein unscheinbarer Burgerladen am Wegesrand auf, der mir vorher noch nie aufgefallen ist und obwohl ich die Strecke schon zigmal gefahren bin – durch meinen Hunger erweitert sich auf einmal meine Realität.

Aktiv? Ebenso klar! Will ich nichts mitbekommen und bin in meine Gedanken vertieft, laufe ich vielleicht schon mal feste gegen eine geschlossene Tür -Smombie halt.

3. Alles ist Simulation!

Doch wieder zurück zu der Sache mit der der Simulation. Der Philosoph Nick Bostrom hat dazu aktuell eine recht radikale Simulationshypothese entwickelt – Alles, vom Urknall, über Galaxien und Atome, Evolution bis hin zum Higgs Bosom ist nur simuliert!!! Wieso? Nun, eine Millionen von Jahre alte posthumane Zivilisation betreibt Forschung und will ihren eigenen Ursprung besser verstehen, fertig!

Das ganze Universum also als berechneter Raum und selbst dazu gibt es Einschätzungen: Seth Lloyd, US-amerikanischer Informatiker und Physiker, schätzte dazu in seinem Aufsatz “The Computational Universe” den Informationsgehalt des Universums seit seinem Anbeginn auf etwa 10120 Operationen bzw. Bits.

4. Beweise durch Fehler in der Simulation

Beweise für die eine oder andere Theorie sind jetzt natürlich schwierig aber nicht unmöglich, jede Simulation hat Fehler und die stellen wir immer häufiger fest.

Zuerst ganz einfach: geht es dir nicht auch manchmal so, das der aktuelle Tag mit nur minimalen Abweichungen den vorherigen Tagen gleicht? Du kommst dir wie in einem Hamsterrad vor? Klar, einen völlig neuen Tag zu programmieren und einzuspielen ist aufwendig. Einfacher ist es, den vorherigen Tag einfach etwas zu modifizieren und wiederzuverwenden – egal ob einfache oder totale Simulation..

Aber auch die aktuelle Physik hat Interessantes zu berichten, nämlich Messungen, die allen Naturkonstanten und Theorien widersprechen – Fehler in der Simulation! So gibt es zum Beispiel Teilchen, die sich mit Überlichtgeschwindigkeit bewegen oder Messungen ungleich verteilter kosmischer Hintergrundstrahlung – und auch das quantenphysikalische Phänomen der Verschränkung – also Informationsübertragung in Echtzeit über beliebige Entfernung hinweg – ist mittlerweile zumindest im Ansatz bewiesen – noch ein Fehler in der Simulation!

Ok, wie dem jetzt auch letztendlich sein mag, ich habe fertig – Kommentare und Kritik [auch vernichtend] sind gerne erwünscht und für mich erst einmal real!

Markus

erfolgreiches Patch Management – 732

Lesezeit 4 Minuten

Werbung

um es gleich auf den Punkt zu bringen:

„Never change a running system“- so lautet eine der goldenen Grundregeln in der IT und heißt auf Deutsch: Finger weg von einem sauber und rund laufenden System! So lässt sich auch erklären, dass in der Finanzbranche doch tatsächlich noch viele uralte Systeme laufen, die in der Jahrhunderte alten Programmiersprache COBOL und in Keilschrift umgesetzt wurden.

Doch die Realität sieht anders aus, aus verschiedenen Gründen muss oftmals ein stabil und rund laufendes System angefasst werden. Da gibt es z.B. Updates für das Betriebssystem, die kritische Sicherheitslücken schließen, oder aber Softwareupdates, die die Stabilität dieser Software erhöhen und neue Funktionalität mit sich bringen – oder aber der Support durch den Hersteller läuft aus.

Für großen Wirbel und manchmal auch blinden Aktionismus hat hier z.B. das Ende des Supports für Win 7 durch Microsoft gesorgt – dessen ungeachtet läuft übrigens auf den meisten Behördenrechnern diese Sicherheitslücke Win 7 noch immer völlig ungestört weiter.

Ist jetzt der endgültige Zeitpunkt gekommen und ein Update steht unweigerlich und hartnäckig vor der Tür, so bedarf dies zuerst buddhistischer Gelassenheit und weiter umfassender und sorgsamer Konzeption, Planung und Umsetzung – Patchmanagement eben!

Testen

Oberstes Gebot im eben beschriebenen Patchmanagement lautet jetzt: Testen, Testen und nochmals Testen! Updates sollten dabei aber nicht nur in einer kontrollierten und definierten Laborumgebung getestet werden – kann man machen, hat aber nur wenig Aussagekraft.

Vielmehr müssen solche Test auf eine breite Basis gestellt werden und dazu müssen Testuser herangezogen werden – aus möglichst unterschiedlichen Abteilungen mit unterschiedlicher Rechnerkonfiguration und Softwareausstattung. So kann man vielleicht schon im Vorfeld feststellen, dass die Finanz- und Buchhaltungssoftware das Betriebssystemupdate nicht so richtig mag, die ganze Sache schon im Vorfeld analysieren und zumindest einen Workaround dafür entwickeln, ohne gleich die gesamte Buchhaltung außer Gefecht zu setzen.

Ach ja, zusätzlich zu der ganzen Vorbereitung, Planen und Testen sollte man vielleicht auch noch einen netten wöchentlichen Newsletter an alle User raushauen und grob über das Vorhaben und den aktuellen Stand der Dinge informieren.

Und spätestens jetzt braucht das Projekt einen richtig knackigen Namen – sowas wie „the next Generation IT“ oder etwas kürzer „thenextGenIT“.

Überhaupt sollte man mal über eine solche proaktive Kommunikationspolitik und regelmäßigen Kontakt mit dem Kunden nachdenken – eben über einen solchen wöchentlichen Newsletter aus der IT!

Und gibt es mal nichts Konkretes zu berichten, so nutzt man den Newsletter zur Userschulung und packt coole LifeHacks rund um Windows, Office oder sonst was rein.

Werbung

Doch zurück zum eigentlichen Thema:

Zusätzlich kannst du mit sehr hoher Wahrscheinlichkeit davon ausgehen, dass es in der hintersten Ecke deines Netzwerks unter Garantie noch eine Software gibt – selbstgeschrieben und uralt, wird auch nur noch von drei Usern benutz, ist aber unglaublich wichtig! – die den Patch ebenso nicht mag und die man trotz genauester Planung einfach übersehen hat – ja wirklich, garantiert!

Zielführend ist es jetzt, ein bereits getestetes PowerShell Script in der Hinterhand zu haben, was den Patch erst mal vollständig von der Platte putzt und den vorherigen Zustand wieder herstellt. So läuft Alles erst mal wieder und man kann sich in Ruhe weitere Gedanken dazu machen.

Werbung

Dokumentation

Das Wichtigste zum Schluss – ok, schon allein das Wort Dokumentation sorgt bei echten ITlern für mittelschweren bis schweren Hautausschlag, bedeutet aber doch nichts weiteres, als festzuhalten, was man gemacht hat und was dabei herausgekommen ist – sehr hilfreich und wichtig für den Überblick – ohne Zweifel!

Völlig verstreute Dokumentation über Ticketsysteme und Excel Tabellen hinweg ist dabei jetzt nicht nur nervig und zeitraubend, eben dieser Überblick kommt dabei nicht zustande. Jetzt muss man aber pragmatisch bleiben und nicht gleich das Rad neu erfinden bzw. eine völlig neue Dokumentation aufbauen.

Vielmehr reicht es oft, die eingesetzten Tools zur Dokumentation nach definierten Kriterien zu analysieren und sich darauf aufbauend für ein bereits vorhandenes Tool zu entscheiden, was zukünftig hauptsächlich genutzt werden soll.

So kann sich z.B. das Ticketsystem als pragmatischste Lösung herausstellen, weil hier zusätzlich Tickets und Reports mit Dokumentation verknüpft werden können oder umgekehrt, was die Aussagekraft der Dokumentation weiter erhöht.

Jetzt nur noch alle alten Excel Tapeten mit dem Ticketsystem verknüpfen oder gleich übertragen – et voilà le travail!

So, ich hoffe das war nützliche Anregung für euer Projekt und viel Spaß mit Euren Anwendern!

(übrigens unter Sysadmins eine böse Beschimpfung: “Du Anwender …!”)

Meinungen oder auch vernichtende Kritik gerne erwünscht!

Markus

weiter mit:

Oumuamua – der Botschafter – 1074

Lesezeit 5 Minuten

So what???

Werbung

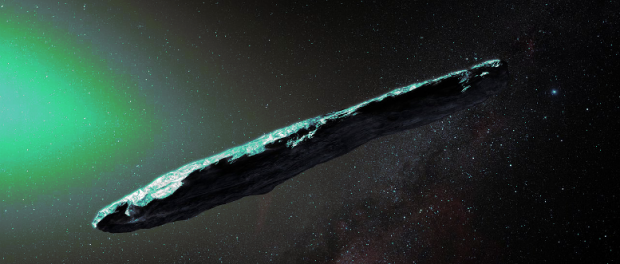

Bereits 2017 sichteten Astronomen mit dem Teleskop Pan-STARRS-1 auf Hawaii – mehr durch Zufall – einen sehr außergewöhnlichen Himmelskörper, daher auch der Name auf hawaiianisch.

Doch der Reihe nach, folgende drei Auffälligkeiten dieses Objekts geben Rätsel auf:

Zuerst stammt dieses Objekt nicht aus unserem Planetensystem wie jeder ordentliche Komet oder Asteroid – also aus dem Asteroidengürtel zwischen Mars und Jupiter, dem Kuiper Gürtel jenseits des Pluto oder der Oortschen Wolke noch dahinter – sondern aus dem interstellaren Raum.

Und dieses Objekt trifft in seiner Flugbahn mit ziemlich strammen 88 Kilometern pro Sekunde oder ca 320 000 Stundenkilometer [die Erde macht gerade mal 30 Km pro Sekunde gleich 107 000 Stundenkilometer] nahezu von oben auf unsere Planetenebene – die Ebene, in der sich alle unsere Planeten um unsere Sonne drehen. Es muss daher aus den Tiefen des Weltalls kommen und kreuzt auf halber Strecke zwischen Sonne und Merkur.

Oumuamua zieht keinen Schweif hinter sich her. Ein gewöhnlicher Asteroid besteht in aller Regel aus gefrorenem Eis und Methan, deshalb auch schmutziger Schneeball genannt. Mit Kurs auf das innere Planetensystem wird ein solcher Asteroid nun durch den Sonnenwind quasi gegrillt, verliert dadurch einen Teil seiner Oberfläche und zieht einen Schweif hinter sich her. Oumuamua muss also etwas Festes aus Gestein oder vielleicht sogar Metall sein.

Die Form! Oumuamua hat eine noch nie bei anderen Himmelskörpern beobachtete Form! Er ist länglich, ja sogar zigarrenförmig und etwa 800 Meter lang – sehr merkwürdig.

Handelt es sich hier jetzt wirklich um ein natürliches Phänomen oder was steckt dahinter?

Werbung

Die uralte Zivilisation

Nun, ganz einfach und jetzt ganz festhalten: es handelt sich hier um ein Generationenraumschiff!

Vor hunderttausenden von Jahren gab es bereits in einer fernen Welt eine hoch technisierte Zivilisation. Die hatte allerdings ihren Heimatplaneten bereits ziemlich runtergerockt und sämtliche Ressourcen waren aufgebraucht. Oder noch schlimmer: der Heimatstern war am Ende seines Lebenszyklus, drohte zu einem weißen Riesen zu werden und damit die inneren Planeten dieses fernen Sonnensystems zu verschlingen. Eine also völlig aussichtslose Lage!

Um die eigene Zivilisation nun zu retten, entschied man sich, einige wenige Auserwählte zum nächsten bewohnbaren Planeten zu schicken um dort neu anzufangen. Man baute jetzt also das Raumschiff für diese Auserwählten – eben genau diese 800 Meter lang. Doch auch die uralte und technologisch fortgeschrittene Zivilisation konnte sich nicht den Gesetzen der Physik entziehen und eine Reise in die neue Heimat würde tausende oder gar zehntausende Jahre dauern, Generationen halt eben.

Deshalb installierte man einfach spezielle Kryocontainer, in denen die Besatzung diese Reise dann eben tiefgefroren antreten kann – das ganze mit einem Materie Antimaterie Generator versehen, der für die nächsten Äonen genug Energie für das Schiff und die Kryokapseln liefert.

Auf der Reise muss dann allerdings etwas fürchterlich schief gegangen sein, das Generationenschiff kam vom Kurs in die neue Welt ab und treibt seitdem ziellos durch die Weiten des Alls – unterwegs durchflog es immer mal wieder interstellare Staubwolken und setze so eine steinerne Außenschicht an.

Der Plan

Was jetzt tun mit Oumuamua?

Von Nutzen wären jetzt die bereits vielfältigen Überlegungen, wie man einen Asteroiden mit Kurs auf die Erde von seinem Einschlag auf die Erde hindern kann – Asteroidenabwehr durch Kursänderung.

So kann man z.B. einen Satelliten mit einer richtig dicken Schubdüse nah genug an das Objekt manövrieren, diese Schubdüse dann in Richtung des Objekts gradgenau ausrichten, zünden und damit die Flugbahn des Objekts leicht verändern – und bloß nicht verrechnen bei der ganzen Aktion! So fliegt der Asteroid mit eigentlichem Kurs Erde vielleicht in nur wenigen hundert Kilometern Höhe an der Erde vorbei, auch wenn es dabei heftigen Satelitenschrott geben dürfte.

Mit der gleichen Methode könnte man jetzt Oumuamua erst einmal abbremsen und dann gezielt in eine stabile Umlaufbahn um die Erde lenken – und wie gesagt, bloß nicht verrechnen!

Technisch sicherlich heikel, aber durchaus machbar – so sind die Japaner erst vor kurzem mit der Raumsonde Hayabusa 2 sogar direkt auf dem Asteroiden Ryugu gelandet – auch nur 900 Meter dick – und haben von dort sogar Proben zurück zur Erde gebracht, crazy!

In einer stabilen Umlaufbahn liegt Oumuamua dann quasi auf dem Präsentierteller und man könnte in aller Ruhe erst mal Sonden nach oben schicken, um die Oberfläche zu untersuchen – kennen wir ja schon vom Mars. Im nächsten Schritt schicken wir Bohrsonden hinauf, die sich dann tiefer in den Untergrund wühlen – kennen wir auch vom Mars, hat da aber noch nicht so richtig geklappt.

Und jetzt wird es spannend: Vielleicht stößt ein solcher Bohrroboter schon nach wenigen Metern Gestein auf die tatsächliche metallische Außenhülle des Generationenraumschiffs! Mit Drohnen erkunden wir dann erstmal vorsichtig das Innere, bevor wir echte Astronauten da reinschicken – und die finden dann in den Kryocontainern eben keine Aliens, sondern echte Menschen!

Werbung

Atlantis

Jetzt wird die Achterbahnfahrt richtig wild! Ja genau, es gibt recht viele Hinweise auf eine hochtechnologische Zivilisation hier auf unserer Erde – noch tausende oder gar zehntausende Jahre vor den alten Ägyptern oder Persern oder wem auch immer und bereits im Kontakt mit extraterrestrischen Zivilisationen – die Präastronautik und van Däniken lassen grüßen. Die traditionelle Archäologie scheut selbstverständlich diese Hinweise wie der Teufel das Weihwasser.

Zum Beispiel die Pyramiden – es wird von der herrschenden Archäologie kolportiert, die Cheops Pyramide wäre in gerade einmal 20 Jahren hochgezogen worden – 4 bis 6 Tonnen schwere Steine, davon 20 Millionen Stück, auf den Zentimeter genau bis auf 145 Meter hoch aufgestapelt und das mit den damaligen primitiven technologischen Mitteln der alten Ägypter, völlig absurd!

Vielmehr stammen diese Pyramiden von dieser vor zehntausenden Jahren untergegangenen Zivilisation und wurden von den Ägyptern einfach nur übernommen und wiederverwendet. Und so geht es weiter im völlig absurden Galopp in der hergebrachten traditionellen Archäologie.

Jetzt darf spekuliert werden, wieso diese uralte Zivilisation untergegangen ist. Die Range reicht dabei von disruptiven gesellschaftlichen Veränderungen wie bei den alten Römern bis hin zu Naturkatastrophen, explodierten Fusionsreaktoren oder Meteoriteneinschlägen, egal.

Was werden wir finden?

Doch zurück zum Generationenraumschiff Oumaumau. Selbst wenn wir dort keine Aliens oder Menschen in Kryocontainern finden oder alle bereits lange tot sind, so wird es dort auf jeden Fall Informationsaufzeichnungen geben. Diese Informationen einer extraterrestrischen oder zehntausende Jahre alten irdischen Zivilisation würde unserer heutigen Zivilisation und Technologie sicherlich einen mächtigen und gewaltigen Schub nach vorne versetzen.

Vielleicht sollte man doch mal bei Elon oder Jeff vorstellig werden und nach den Milliarden fragen, die sie so rausrücken könnten, um dieses Projekt umzusetzen – und bevor Oumuamua wieder in den Tiefen des Alls verschwunden ist.

Ach, und eine Sache noch: wieso hatten wir bis jetzt noch keinen Kontakt mit hochentwickelten extraterrestrischen Zivilisationen? Hatten wir, allerdings schon mehrere zehntausend Jahre her! Jetzt liegt unsere Erde in einem großen kosmischen Naturschutzgebiet! Man darf uns nur noch beobachten, aber nicht mehr aktiv Kontakt aufnehmen und so unsere Entwicklung beeinflussen – ganz einfach.

Werbung